Tokenisation : McKinsey s’attend à une lente progression

Selon le cabinet McKinsey, la tokenisation des fonds devrait prendre plus de temps que prévu. Elle atteindra seulement 2 000 milliards de dollars d’ici 2030, hors cryptomonnaie et stablecoins. Cette progression s’appuiera en grande partie sur les fonds communs de placement, les obligations et les bons du Trésor négociés en bourse (ETN).

Dans une nouvelle étude parue en fin de semaine dernière, McKinsey donne une idée de l’évolution des actifs numériques dans les prochaines années. Selon le cabinet de conseil, la tokenisation des fonds, c’est-à-dire leur inscription sur une blockchain privée ou publique, devrait prendre plus de temps que prévu.

McKinsey prévoit 2 000 milliards de dollars de fonds en tokens

Alors que les marchés s’attendaient à des dizaines de milliards de dollars d’ici la fin de la décennie, McKinsey voit une capitalisation boursière de 1 000 milliards de dollars dans le scenario le plus pessimiste et de 4 000 milliards dans le plus optimiste. D’où une estimation moyenne de 2 000 milliards de dollars. Cette valorisation ne concerne pas les cryptomonnaies comme Bitcoin, les stablecoins comme Tether, ainsi que les monnaies numériques des banques centrales (CBDC). Leur prise en compte pourrait fausser le calcul avec les doubles comptages.

8,4 milliards de dollars placés actuellement

McKinsey a reposé son estimation sur l’adoption des fonds communs de placement, des obligations et bons du Trésor négociés en bourse (ETN), des prêts et de la titrisation, ainsi que des fonds alternatifs. Actuellement, le cabinet évalue la tokenisation des actifs du monde réel (RWA) à plus de 8,4 milliards de dollars, avec la participation de grandes sociétés financières telles que BlackRock.

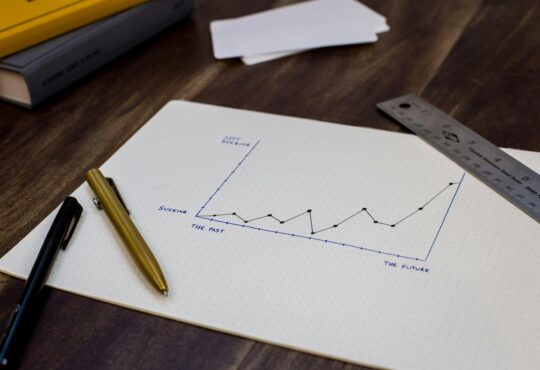

McKinsey ne voit pas de tsunami de tokens, mais des vagues successives

Avec ces estimations, McKinsey minore considérablement l’ampleur de la déferlante attendue de la tokenisation. Selon l’agence, l’on ne devrait pas s’attendre à un tsunami, mais des vagues successives. La première viendra des cas d’usage avec un retour sur investissement prouvé et un effet d’échelle réel. Il y aura ensuite les cas d’usage des classes d’actifs, qui nécessitent des solutions à des défis techniques plus compliqués. Les marchés à ce niveau sont d’ailleurs plus petits, et les avantages moins évidents.

Une lente progression à cause de faux départs et défis

La lente progression de la tokenisation s’expliquerait par de nombreux faux départs et défis liés à la blockchain. Notamment une faible intégration de cette technologie dans le courant dominant et une faille dans la sécurité. McKinsey relève aussi des couacs dans la coopération et l’harmonisation entre les parties prenantes concernées. Le cabinet international juge indispensable de numériser les actifs à mesure que le système évolue et présente des avantages économiques.

McKinsey fait des recommandations

McKinsey recommande également d’inclure de nouvelles fonctionnalités. Parmi lesquelles, la disponibilité 24h/24 et 7j/7 ; la mobilité mondiale instantanée des garanties ; l’accès équitable aux tokens; la composabilité ; et une transparence gérée. Le cabinet new yorkais reconnaît toutefois que la modernisation de l’infrastructure existante reste un défi majeur, en particulier dans un secteur très réglementé comme celui des services financiers.